Apprentissage de comportements hiérarchiques :

étude comparative entre l'apprentissage développemental et l'apprentissage par renforcement

Rémi Casado / remi.casado@etu.univ-lyon1.fr

M2-IADE, LIRIS, Université Claude Bernard Lyon 1

Laëtitia Matignon / laetitia.matignon@liris.cnrs.fr

Introduction

Cadre du sujet

Exemples d'applications

Introduction

Apprentissage développemental (Georgeon, 2014)

Introduction

Apprentissage par renforcement (Sutton et Barto, 1998)

“Reinforcement learning is learning what to do -how to map situations to actions- so as to maximize a numerical reward signal.”

Introduction

Objectifs de l'étude

Sommaire

- Formalisme 7

- Problèmes X*Y* 16

- Small loop problem 24

- Synthèse / Conclusion 26

Formalisme

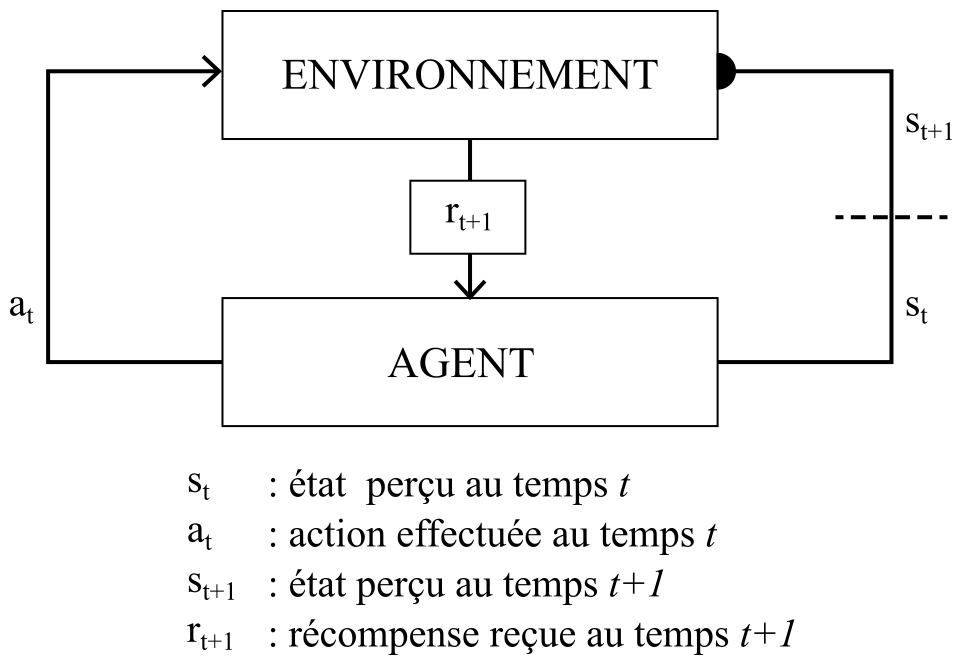

Apprentissage par renforcement

Apprentissage par renforcement

- L'agent effectue une action choisie en fonction de l'état qu'il vient de percevoir.

- L'environnement retourne alors son nouvel état, et la récompense correspondante à cet état.

Apprentissage par renforcement

Formalisme

Processus de décision markovien (MDP)

Processus de décision markovien (MDP)

Formalisme

Processus de décision markovien partiellements observables (POMDP)

MDP partiellements observables (POMDP)

Formalisme

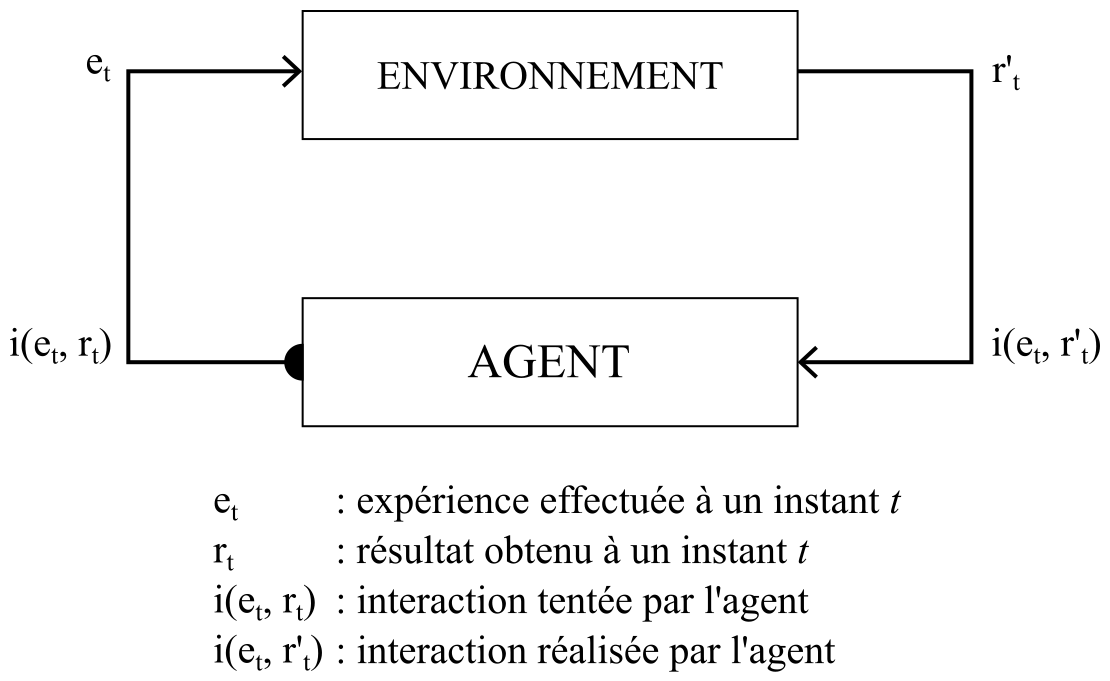

Apprentissage développemental

Apprentissage développemental

- L'agent initie les échanges avec son environnement en essayant de réaliser une interaction.

-

L'agent va être motivé par deux éléments:

- La valence propre à une interaction, qui va influencer ses préférences.

- Sa capacité à prédire les interactions qu'il réalise.

(Georgeon et Cordier, 2014)

Problèmes X*Y*

Problème XY

Problème XY

- L'agent peut effectuer deux actions X et Y.

- L'environnement possède deux états SX et SY.

- L'agent n'a pas accès à ces états, mais reçoit une unique observation quelle que soit l'action qu'il effectue.

(Singh et al., 1994)

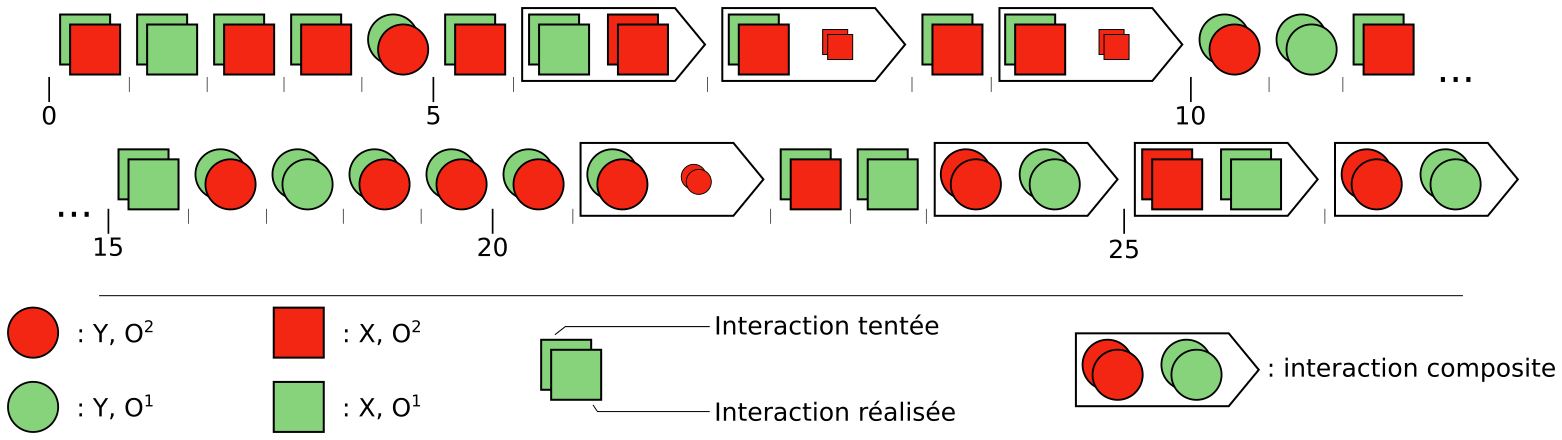

Problèmes X*Y*

Problème XXYY

Problème XXYY (Georgeon et al., 2009)

Un benchmark pour l'apprentissage développemental inspiré du problème XY

- Alterner XX, YY

- L'agent va devoir choisir de subir une récompense négative pour ensuite avoir une récompense positive

Une modélisation de ce problème pour l'apprentissage par renforcement

-

États : {XX, XY, YX, YY} / Actions : {X,Y}

Observations : {o1,o2} / Récompenses : {r(o1) = +1, r(o2) = -1} -

Par exemple:

- st = XX, at = X ➝ ot+1 = o2

- st = XY, at = Y ➝ ot+1 = o1

Problème XXYY

On observant les propriétés du problème XXYY, nous avons l'intuition qu'il faut doter l'agent d'une mémoire de ses actions passées.-

On s'inspire des Trajectoires d'Observation-Action (Dutech et Samuelides, 2003)

- Historique des dernières séquences d'observation-action entre l'agent et l'environnement

- Va permettre de compléter notre POMDP pour le ramener à son MDP sous-jacent

-

On remanie ces Trajectoires d'Observation-Action dans le but de se rapprocher du modèle interactionnel de l'apprentissage développemental

- On va utiliser des Trajectoires d'Action-Observation (TAO)

- Ces TAOs vont faire office d'état dans le cycle d'apprentissage pas renforcement.

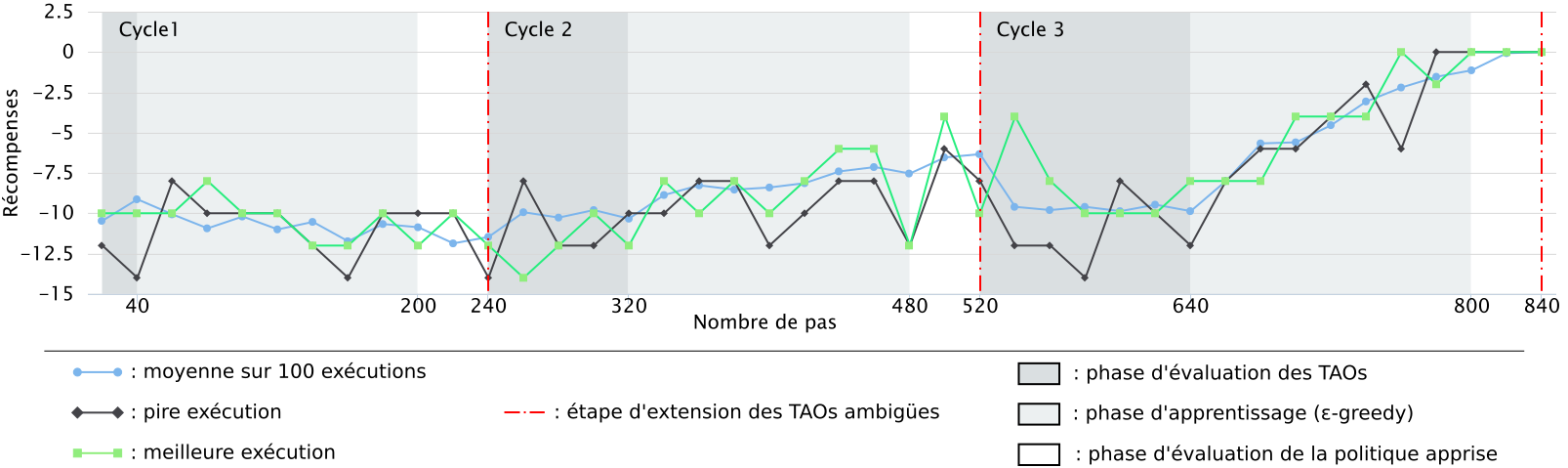

Problème XXYY

Problème XXYY

Application des TAOs pour la résolution du problème XXYY avec un apprentissage par renforcement

- Détection de TAOs ambigües selon 3 critères(Dutech et Samuelides, 2003) :

- Vitesse de convergence

- Nombre d'utilisations

- Ambiguité dans le choix de la meilleure action à effectuer

- Résultats obtenus (sur 100 exécutions)

Résolution de XXYY par apprentissage développemental

Small loop problem

Small loop problem

Synthèse et Conclusion

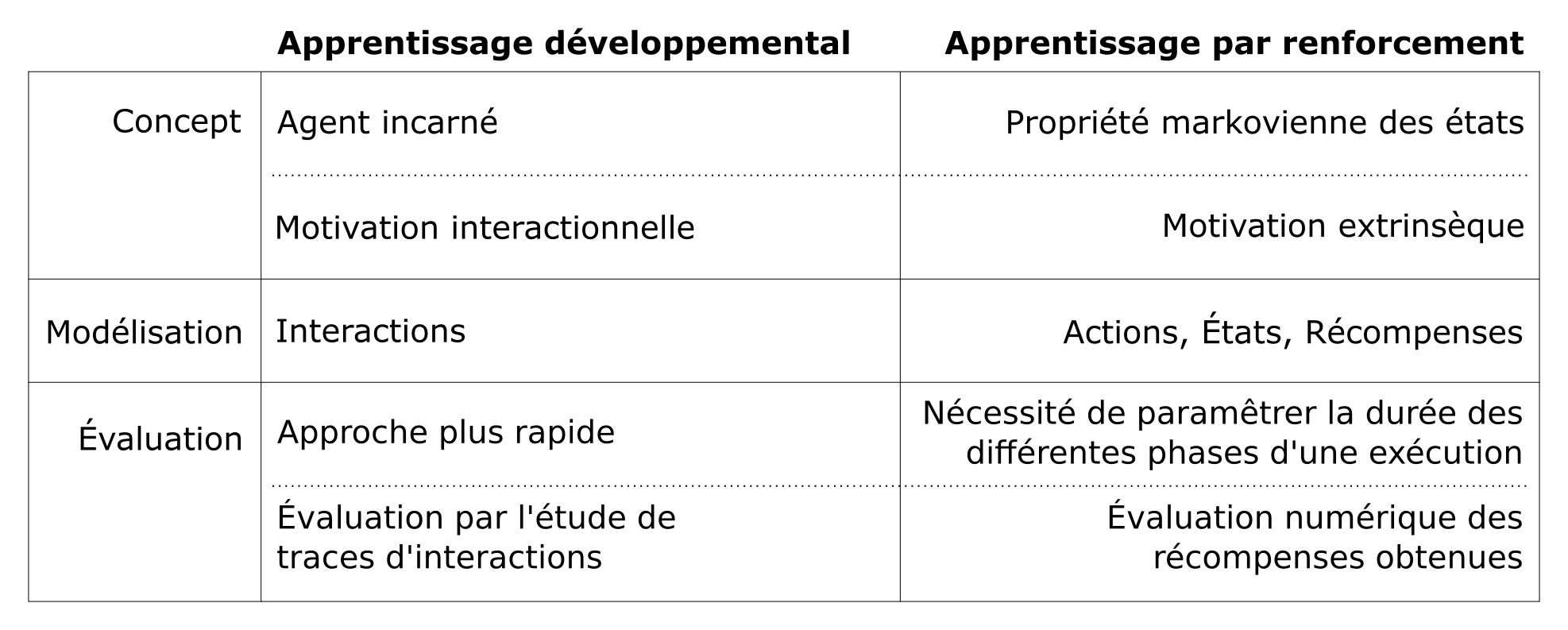

Synthèse

Conclusion

La majeure partie des différences entre l'apprentissage développemental et l'apprentissage par renforcement vient du fait que leurs objectifs respectifs diffèrent.

En effet, le but de l'apprentissage développemental va être de fournir à un agent incarné les moyens de construire des comportements sur la base des régularités qu'il va observer dans ses interactions.

D'un autre coté, l'apprentissage par renforcement va chercher à associer des états (en général markoviens) à des actions pour maximiser une récompense extrinsèque.

On pourra néanmoins tirer profits des différences dans les mécanismes de chaque méthodes pour lever des barrières que ces deux approches peuvent rencontrer.